Mit Hilfe der Deutschen Bundesstiftung Umwelt wurde von der Universität Lüneburg (2012) eine Virtuelle Akademie Nachhaltigkeit etabliert, auf der videobasierte Vorlesungen zu „Nachhaltigkeitsthemen“ angeboten werden, die man im Selbststudium belegen kann, und deren vergebene Creditpoints in Studium Generale anderer Universitäten anerkannt sind. Das ist eine überfällige gute (wissenschaftliche) Weiterbildungseinrichtung, die noch dazu z.Zt. unengeltlich absolviert werden kann, die Thematiken anbietet, die so an den meisten Universitäten gar nicht vorhanden sind. Da die Materialien der Akademie als Creative Commons (freie Lizenzen) angeboten sind, können sie auch gut in der Lehre bausteinweise Verwendung finden, ohne dass dabei das Copy Right verletzt wird.

Zu den Angeboten zählt auch die von Gerhard de Haan (Institut Futur, Freie Universität Berlin) entwickelte Vorlesungsreihe „Bildung für nachhaltige Entwicklung“. Seit den ersten Dokumenten zur BNE (Orientierungsrahmen BNE der BLK 1998 und Programmbeschreibung BNE von de Haan/Harenberg aus dem Jahr 1999) gab es meines Wissens keine geschlossenen Gesamtbeschreibung mehr. Auch auf der Hompage zur Dekade findet man nur Rudimentäres zur BNE, und es existieren natürlich über die Jahre eine Fülle von Einzelbeiträgen zur BNE. So muss man dem wesentlichen Schöpfer und Vertreter der BNE Deutschlands dankbar sein, dass er sich die Zeit für eine so umfassende Darstellung (13 Vorlesungen) genommen hat, die man als Massstab für das nehmen kann, was die heutige Mainstream BNE in Deutschland darstellt. Das Format einer Videovorlesung (Vortragender plus ppt-Folie) ist konservativ aber effektiv und wird über ein jeweils anschließendes Interview pro Vorlesung mit Dr. Marianne Dehne etwas aufgelockert.

Vieles hier Gesagte ist gut und richtig, aber – wie kann es anders sein – ein paar wesentliche Stolpersteine finde ich nach einer exemplarischen Teilsicht an diesem Konzept, die ich hier kurz aufweisen möchte.

1. Mangel der politischen Brisanz im Nachhaltigkeitskonzept

Es ist gut, dass hier de Haan auf die Wurzeln der BNE genauer eingeht. Die Gemengelage 3. und 1. Welt vor und z.Zt. des Brundtlandberichtes, wird angedeutet, aber m.E. nicht zuende gedacht. Die Länder (insbesondere die Eliten) der 3. Welt wollten Entwicklung, und die ökologisch angehauchten erste Welt Vertreter wollten „smal is butiful“ bzw. „limits to growth“. „Umweltschutz können sich die Reichen leisten“, war die berühmte Antwort Indira Gandhis auf der Stockholmkonferenz. D.h. die gefundene Formel „Sustainable Development(SD)“ stellt eine höchst fragile Leitplanke dar, die jeder nach Gusto verschieben konnte. Die 3. Welt wollte einen Entwicklungsgipfel in Rio und hat sich nur unter Murren auf einen Gipfel Entwicklung + Umwelt eingelassen. Was wir mit „Nachhaltigkeit“ anstreben, ist vom Ursprung her nicht etwas Sinnvolles, kein naheliegendes Entwicklungsziel, sondern es war schlicht eine Kompromißformel. Im Brundlandtbericht steht klar und deutlich SD ist ein politisches Konzept. Das war eine weitsichtige Feststellung, denn wie wir (vielleicht leider) bei allen Rio-Nachfolgekonferenzen, insbesondere den Klimakonferenzen, sehen müssen, wird der „richtige“ Pfad in die Zukunft unter den Beteiligten politisch und nicht ökologisch verhandelt. Erkenntnisse der Klimaforschung werden von den Politikern solange wahrgenommen, solange es ihnen förderlich ist, ansonsten werden sie bestritten oder einfach ignoriert. Die Vorlesung zu den Reflexionen zur starken und schwachen Nachhaltigkeit, die über die Frage der Substituierbarkeit von Naturkapital geführt werden, hätte sich de Haan schenken kölnnen. Das sind nette intellektuelle Spielereien, die mit Rio nichts gemein haben. Starke Nachhaltigkeit setzt das Primat der Ökologie voraus, was in Rio nirgends postuliert wurde.

Die Ausgangslage des faulen Kompromisses SD wird von de Haan zu wenig gewürdigt. Sie spielt jedoch bei der Beurteilung der Bildungspostulate der Agenda 21 eine wesentliche Rolle. 1992 war die Blütezeit des Liberalismus. Die Zentralverwaltungsstaaten kommunistischen Prägung waren gerade zusammengekracht. Die freien marktwirtschaftlich organisierten Staaten triumphierten. In einer solchen Lage hatten staatliche Verordnungen z.B. zur CO2-Emissionsbeschränkung, zum Ressourcenschutz, zur Bekämpfung der Armut etc. keine Chancen. Anstatt staatlich gesetztes Benchmarking der sozialen und ökologischen Zumutungen global zu verhandeln, wurde die Bildung ins Feld geschickt. Das handelnde, aufgeklärte Individuum wird es mit seinen nachhaltigen Werteeinstellungen schon richten. Der Gedanke der lokalen Agenden war zumindest für demokratische entwickelte Gesellschaften ein liberales Kuckucksei. Neben die demokratisch legitimierten staalichen kommunalen Organe wurde eine demokratisch nicht legitimierte „private“ Agenda-Allianz mehr oder weniger dubioser Akteure gesetzt, die plötzlich an runden Tischen eigene Leitbilder über die Zukunft der Kommune entwickeln wollten. Das musste schief gehen, und hat auch nur da geringe Erfolge gezeigt, wo man rechtzeitig erkannte, die kommunalen Organe gebührend einzubinden.

Bildung wurde in Rio als Bewußtseinserweckungsmechanismus instrumentalisiert, und jeder, der sich mit Bildungssystemen auskennt, musste angesichts der Forderungen im Kapitel 36 den Kopf schütteln, weil es natürlich nicht gelingen würde, BNE in allen Bildungsbereichen zu integrieren.

Mein Credo: Eine Bildung, die übersieht (oder vertuscht) dass der Weg zu einer zukunftsfähigen Entwicklung immer auch ein Weg gegen anders geartete Interessen ist, also ein politisches Minenfeld mit Gewinnern und Verlierern, hat den Namen BNE nicht verdient. BNE ist kein neutraler Werkzeugkasten, mit dem sich nachhaltige Zukunft einfach basteln läßt. Bei aller Anbindung an natur-, wirtschafts- und sozialwissenschaftliche Erkenntnisse, ist BNE vor allem auch politische Bildung. Leider kommt das in der deutschen, wesentlich schulorientierten BNE sehr wenig zum Vorschein.

2. Überschätzung der Rolle der Bildung für den Bewußtseinswandel

Der O-Ton des Kapitel 36 der Agenda 21 bzgl. Bildung heißt: Bewußtseinsschaffung für eine nachhaltige Entwicklung. Ich hatte es immer für einen geschickten Schachzug de Haans bei der deutschen Ausprägung der BNE gehalten, dass er unter Umgehung der Riodiktion nicht die BNE als Nachhaltigkeitsgesinnungsinstrument sondern als ein Kompetenzerwerbsinstrument mit der Konstruktion der Gestaltungskompetenzen entwickelt hat. Mitte der 90er, als die Riodebatte mit der Studie „Zukunftsfähiges Deutschland“ anhob, war nämlich klar geworden, dass mit der normativen Zeigefinger-Umweltbildung, oder der Katastrophenbildung keine neuen Teilnehmer in die entsprechenden Angbebote zu holen waren. „Die Klimakatastrophe kommt, Du musst Dich ändern!“ – dieser Slogan hatte an Attraktivität schwer eingebüßt. Den konnte man nun nicht einfach ersetzen durch: „Werde nachhaltigkeitsbewusst, sonst gehts Deinen Enkeln schlecht und die 3. Welt leidet!“ Der Kompetenzschlenker jenseits von Rio war auch eine richtige Konzession an moderne Bildungstheorien, die der Belehrungspädagogik Rioscher Prägung widersprachen. Nun aber, in den Videovorlesungen wird an mehreren Stellen der Bildung mehr handlungsorientierende Kraft zugeordnet, als mir statthaft scheint. Wenn auch de Haan nicht von Nachhaltigkeitserziehung spricht, so ist ihm aber doch die Bildung als Agens zum Handeln im Sinne einer zukunftsfähigen Gesellschft sehr wichtig. Bildung als Voraussetzung für „richtiges“ Handeln und für die „richtigen“ Einstellungen (Mentalitätswandel) ist m.E. aber weder notwendig und schon gar nicht hinreichend. Die Deutschen haben um 2007 als die Ölpreise hoch und die ökonomische Lage gut war, eine hohe pro-Energiewende-Einstellung verzeichnet. Das Nachhaltigkeitswunder gelang, dass in einer wirtschaftlich hoch entwickelten Nation eine Abkehr von Atom und Karbonstoffen zugunsten der Erneuerbaren eingeleitet wurde. Heute, wo die Öl- und Kohlepreise tief, und die Konjunktur schlecht ist, erhält die Partei, die das wesentlich vorantrieb, eine Niederlage, und die Stimmen zur Energiewendebremse erstarken. Solche Bewußtseinskonjunkturen belegen ganz eindeutig, dass hier eine Vielzahl von Faktoren wirksam werden, wobei konkrete Bildungskonzepte eine ehr mariginale Rolle spielen dürften. Dass es der Bildung bedarf, um den Herausforderungen kommender Gesellschaften gewachsen zu sein, ist ja ein Allgemeinplatz. Aber – und hier liegt auch ein großes Problem der allgemein gehaltenen (nicht domainspezifischen) Gestaltungskompetenzen – mit einer guten Bildung, mit selbstbewußten Individuen kann ich Gutes und Böses erreichen.

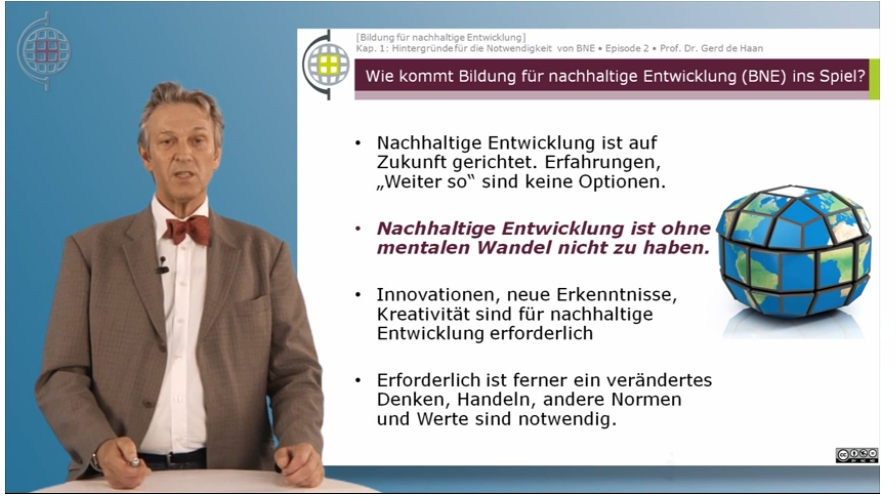

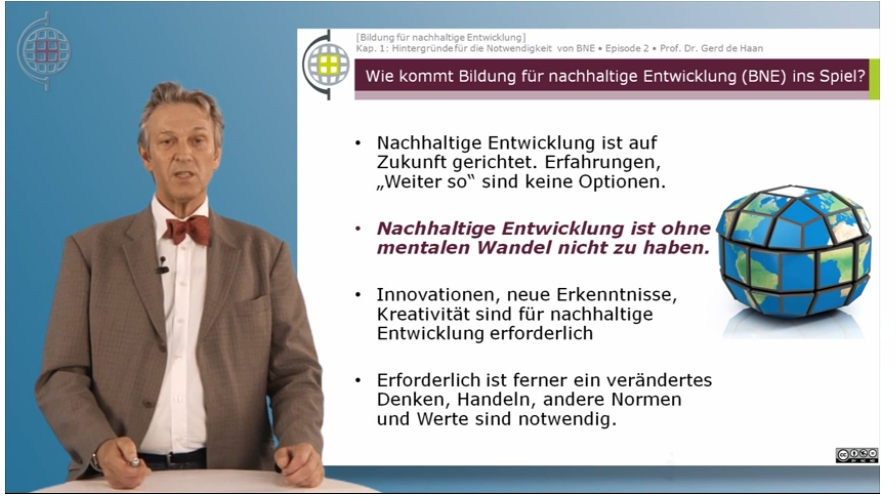

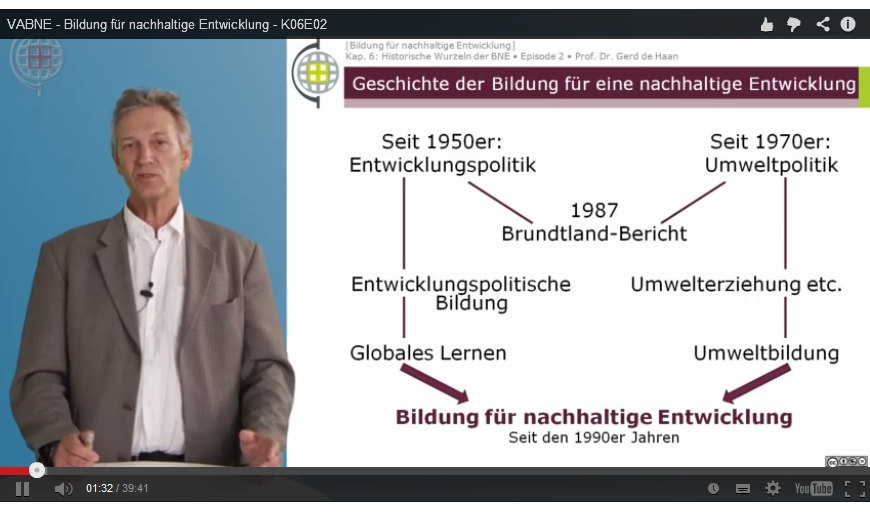

Screenshot aus der Vorlesungsreihe BNE de Haan

Jede Entwicklung, auch die der Ölmultis ist in die Zukunft gerichtet. Innovationen und Kreativität brauchen die Ressolurcenvernichter so wie deren Erhalter. Selbst neues Denken, sich auf das Fremde einstellen, brauchen die globalen Unternehmen, um erfolgreich am Markt zu bleiben. Leider gilt der Satz, dass eine innovative, kreative Bildung kein Alleinstellungsmerkmal derer mit guten Absichten ist. Welches Handeln ein BNE-zertifizierter Lerner einmal einschlägt, bestimmt nicht Gerhard de Haan, sondern der Lerner selbst in seinen Lebensumständen.

Mein Credo: Du kannst Leute nicht bekehren, aber Du kannst sie qualifizieren! Und darauf sollte BNE mehr Gewicht legen.

3. Die Rolle des Globalen Lernens im deutschen BNE-Konzept

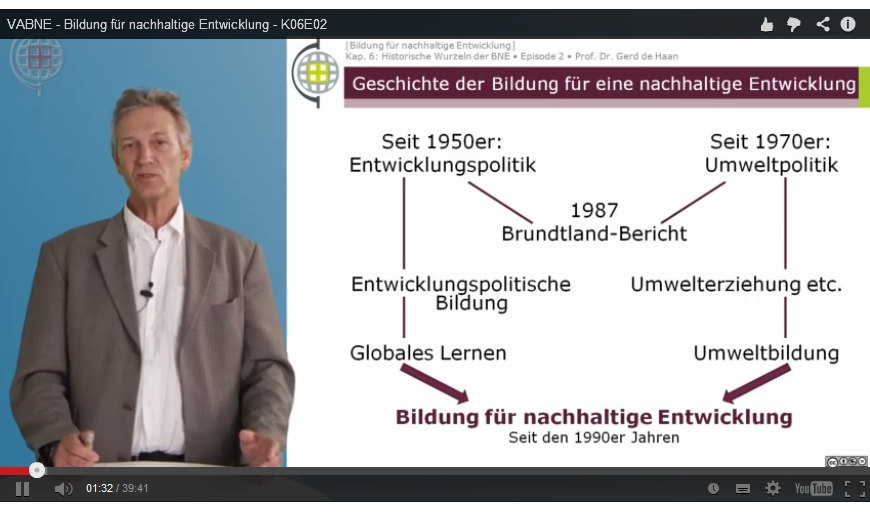

Es gibt folgende „Mogelgrafik“ in de Haans Vorträgen:

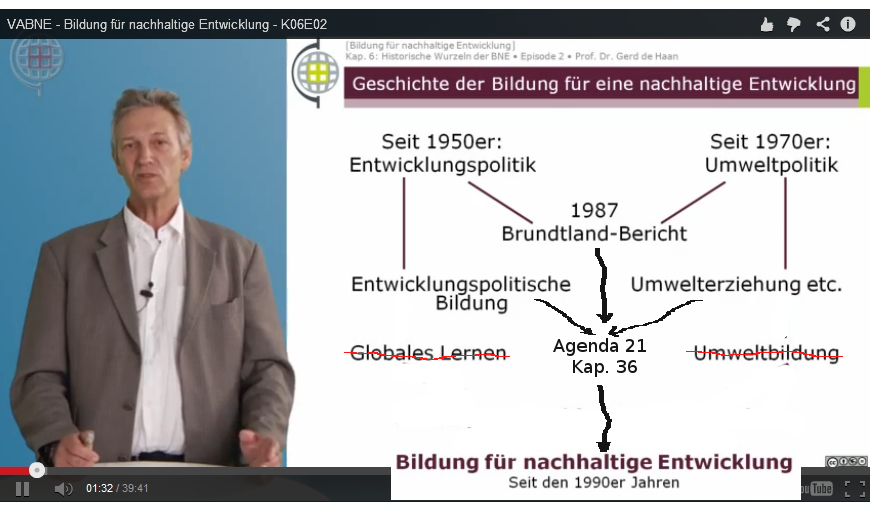

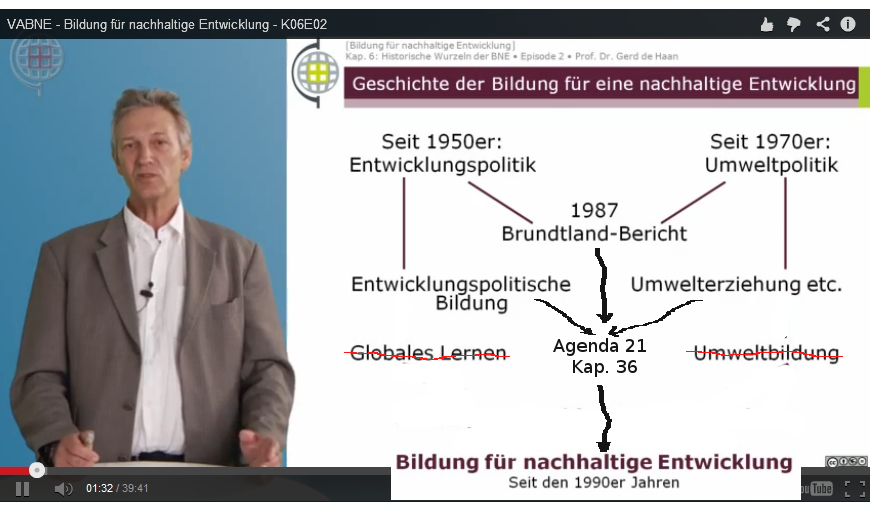

Hier fehlt das wesentliche Glied Rio, bzw. das Kapitel 36 der Agenda 21, in dem postuliert wurde, dass die entwicklungsorientierte Bildung und die Umweltbildung zur BNE verschmelzen sollen. Die Grafik müßte korrekterweise so aussehen:

leicht veränderte Grafik in de Haans Videopräsentation

D.h. „Globales Lernen“ hat in Rio keinen Platz, dessen Ursprünge sollten zusammen mit der Umweltbildung im neuen BNE aufgehen.

Die Eine Welt-Gruppen, die die entwicklungsorientierte Bildung pflegten, hegten sehr früh Kritik an der BNE, dass sie unpolitisch und zu ökolastig sei. Ein Grund für diese unsinnige Spaltung in zwei Linien lag wohl darin, dass die „alte“ Umweltbildungsszene in die Fussstapfen der BNE trat (daher auch die Ökpolastigkeit), und die „alte“ Entwicklungsbildungsbewegung päppelt ihr Bildungskind, Globales Lernen“. Keiner wollte als Platzhirsch zurücktreten. Auch von mir in meiner Zeit als Vorsitzender der Kommission BNE in der DGFE unternommene Versuche, die beiden Lager zu vereinen, gelang nicht, und als dann 2007 das Entwicklungsministerium einen Orientierungsrahmen Globales Lernen herausgab, war die Trennung zementiert.

Mein Credo: Konkurrenz belebt zwar das Geschäft, und Vielfalt mag gut sein, aber Vielfalt verwirrt auch und schwächt, wenn es darum geht, Flagge zu zeigen und eine Sache nach vorne zu bringen.

4. BNE und Erwachsenenbildung

In der 11. Vorlesung geht de Haan auf den Stand in aussgewählten Bildungsbereichen ein. Hier legt er sehr ehrlich offen, dass die BNE in allen Bereichen weit weniger etabliert ist, als das wünschbar wäre. Es verwundert aber, dass hier nur die Primarstufe (wo bis vor kurzem ein von E.ON gesoponsertes sehr großes Fortbildungsprojekt für Kindergärtnerinnen vorlag), wesentlich die Hochschule und etwas die berufliche Bildung und das informelle Lernen Erwähnung finden. Aus meiner Sicht stammt die Blütezeit der BNE aus den beiden BLK-Projekten „21“ und „Transfer 21“ von 1999 bis 2007, wo mit großem Einsatz wesentlich in den Schulen Material entwickelt und Projekte erprobt wurden. Dieser Schwerpunkt, dem nur noch die Dekade folgte, für die es aber kein Geld, und deshalb keine Entwicklungsförderung gab, hatte zur Folge, dass die heutige BNE wesentlich eine „Schul-BNE“ ist. Sie fügt sich voll in curriculare Kontexte, ein (grober) Inhalts-, ein Methoden-, und ein Kompetenzrahmen sind vorgegeben. Die Lernenden haben zu inhalieren, was die Planer vorgedacht haben. Das ist für Schulkontexte, wo man einen Bildungskanon verordnet, um dafür ein Zertifikat auszuwerfen, auch richtig, wenn da nicht der kleine Schönheitsfehler wäre, dass die BNE-Rechnung ohne die Kultusminister der Länder gemacht wurde, d.h. die zu erzielenden Gestaltungskompetenzen sind nicht unbedingt diejenigen der jeweilig geforderten Fachkompetenzen der Länder. Da es nun auch einen Orientierungsrahmen für das Globale Lernen gibt, steht noch ein Kanditat vor den Ländertüren und bitte um Curriculareintritt.

In der Erwachsenenbildung herrscht salopp gesagt das Problem, dass wer kein Interesse an Nachhaltigkeitsfragen hat, der fragt auch keine BNE-Angebote nach. Wer aber ein nachhaltigkeitsrelevantes Problem in seinem Entscheidungsumfeld hat, und damit auch schon ein gewisses Bewußtsein mitbringt, der sucht in der Regel ein spezifisch für sein Bedarf zugeschnittenes Angebot. Während schulische Konzepte angebotsorientiert sind, verfährt die Erwachsenenbildung nachfrageorientiert. Das führt nach BNE-Diktion eher zu „unterkomplexen“ Angeboten, sie können rein technischer, wesentlich wirtschaftlicher oder anderer „einseitiger“ Natur sein. Diese Angebote, mit denen eine Nachhaltigkeitsfrage gelöst werden kann, genügen aber nicht den Kriterien, die für die BNE gelten, es fehlt u.U. die intergenerationelle Komponente, es wird keine Empathie für die Eine Welt erzeugt, es werdeen die sozialen Bedingungen gekappt, die hinter den behandelten Prozessen stehen, etc. Dieser absurde Umstand, dass ein Bildungsangebot hilft, ein nachhaltigkeitsrelevante Entscheidung zu stärken, aber selbst nicht als BNE eingestuft wird, kann ja wohl nicht gelten! D.h. für die nicht auf Zertifizierung zielende Weiterbildung oder auch für die ausserschulische Bildung, die nichtschulische Kontexte bedient, muss man sich bzgl. des BNE-Konzeptes etwas mehr einfallen lassen, das den curricularen Rahmen und die kanonisierten Gestaltungskompetenzen der „Schul-BNE“ hinter sich läßt. Zu diesen Fragen habe ich bei meiner stichprobenhaften Sicht der Vorlesungen nichts gefunden. Vielleicht habe ich da ja etwas übersehen.

5. BNE und Umweltbildung

Im Rückblick, was vor BNE war, zählt de Haan in der 6. Vorlesung (Historische Wurzeln) auf:

– Umwelterziehung

– Ökologisches Lernen

– Ökopädagogik

– Umweltbildung

D.h., hier wird Umweltbildung als eigenständige Kategorie genannt. Das entspricht m.E. nicht dem allgemeinen Verständnis. Umweltbildung steht für einen Begriffs-Kontainer, der all die Ansätze charakterisiert, die vor (und nach) Rio als Bildungsansätze Umweldfragen thematisiert haben. (vgl. z.B. Gerd Michelsen , Theoretische Diskussionsstränge der Umweltbildung, in: Beyersdorf/Michelsen (Hrsg.) Umweltbildung 1998). Im Interviewteil äußert sich de Haan auf die Frage, wie diese früheren Ansätze zueinander stehen, dass es sie noch gibt, dass aber eine Umweltbildung ohne Bezug auf Nachhaltigkeit heute undenkbar sei. Noch stärker ist die Verabschiedung der Umweltbildung bereits im Orientierungsrahmen zu lesen, wo die BNE als das Modernisierungskonzept der Umweltbildung angepriesen wird. Umweltbildung ist also altmodisch, oder hat keine Berechtigung. Dieses Verdikt ist besonders im Hinblick auf Erwachsenenbildung/Weiterbildung unangemessen. Auf dem Bildungsmarkt existiert eine relativ konstante Nachfrage nach Umweltbildung. Eltern wollen den Streichelzoo, Menschen interessieren sich für das Biotop nebenan, Jugendliche wollen Kröten das Leben retten, etc. Man kann diesen Umweltbildungsnachfragenden nicht sagen, sorry, Du fragst hier was Falsches nach, du musst Dich um Nachhaltigkeit kümmern. Es gibt nicht nur eine Umweltbildungsnachfrage, sie ist sogar erheblich größer als die nach BNE. Wer ernsthaft Umweltbildung verbieten würde, nimmt den meisten Umweltzentren die Existenzgrundlage.

Mein Credo: Dass Umweltbildung in Deutschland seit der BNE-Debatte zum Stiefkind geriet, der man sich mehr schämt, als sie offen zu betreiben, war eine Fehlentwicklung. Eine Bildung, die sich wesentlich auf ökologische Fragen konzentriert, und die Randdisziplinen, nur wenn es passt, und wenn es nachgefragt wird, mit integriert, ist existent, und sollte auch theoretische Unterstützung erfahren. Was ist falsch daran, dass Umweltbildung neben BNE angeboten wird mit fließenden Übergängen?

Insgesamt bleibt freilich festzuhalten, dass diese Vorlesungsreihe ein großartiges Angebot darstellt, sich intensiv mit dem BNE-Konzept zu befassen. Zu den begleitend angebotenen Selbststudienmaterialien und der didaktischen Durchführung des Studiengangs kann ich nichts sagen. Es wäre interessant, wenn sich dazu hier ein Kommentar einstellen würde.

Internetnutzer frage ich mich, wie es mit dem NSA-Skandal durch die Snowden-Enthüllungen des Jahres 2013 weiter gehen wird. Dazu brauche ich natürlich nur ins Netz oder in die Zeitung zu schauen. Fangen wir mit der FAZ vom 12.Jan.2014 an, da feuilletonisiert Sascha Lobo über die digitale Kränkung des Menschen. Er habe immer auch die Netzwerke gegen Kritiker hochgehalten, das Internet für einen Hort der Demokratieverbreitung angesehen – und nun kam der Spähskandal und der Kontrollwahn der Konzerne. Er muss einsehen, er war naiv, jetzt habe sich alles verändert. Wer als Experte für eine Sache einen großen Irrtum zur Sache einräumt, ist ehrenwert.

Internetnutzer frage ich mich, wie es mit dem NSA-Skandal durch die Snowden-Enthüllungen des Jahres 2013 weiter gehen wird. Dazu brauche ich natürlich nur ins Netz oder in die Zeitung zu schauen. Fangen wir mit der FAZ vom 12.Jan.2014 an, da feuilletonisiert Sascha Lobo über die digitale Kränkung des Menschen. Er habe immer auch die Netzwerke gegen Kritiker hochgehalten, das Internet für einen Hort der Demokratieverbreitung angesehen – und nun kam der Spähskandal und der Kontrollwahn der Konzerne. Er muss einsehen, er war naiv, jetzt habe sich alles verändert. Wer als Experte für eine Sache einen großen Irrtum zur Sache einräumt, ist ehrenwert. Er denkt das nicht allein, bei WIRED (Link des nebenstehenden Logos) wird weniger psychisch, dafür mehr sachlich auch über Naivität des Experten und von Balkanisierung des Internet (ein Spruch von Zuckerberg) gesprochen. Der WIRED-Autor Steven Levy rekapituliert die amerikanische Story, wie nach der Snowden-Enthüllung erst mal die großen Internetgiganten geleugnet haben, wie dann über Nachfragen aber doch zutage kam, dass sie alle ihre Datenströme der NSA übergeben, und das aufgrund der amerikanischen Gesetzgebung (FISA Amendments Act von 2008), wobei die Geheimdekrete ihnen sogar verbieten, darüber zu reden. WIRED geht es weniger um Moral und Kränkung, sondern um ökonomische Kollateralschäden einer wahnwitzigen Terrorbekämpfung, denn ein wesentliches Kapital, dass die Nutzer ihre Daten auf Amiserver schicken, besteht im Vertrauen. Und wenn dieses zerstört ist, ziehen die Firmen ihre preiswerte Datenlagerung in Clouds zurück. Die Kunden werden misstrauisch und verlassen vielleicht die amerikanisch betriebenen Plattformen. Und wenn sich gar durchsetzen würde, was in Brasilien, Malaysia, Frankreich und in der EU angedacht wird, das Internet zu nationalisieren („Splinternet“), dann wäre das der Tod des Internets, denn der aktuelle Gewinn liegt ja gerade darin global Zugang zu allen Daten zu haben. Wer dann in Brasilien im Hotel ins Netz geht, wird seine Mails aus Deutschland nicht mehr abrufen können. In Facebook gäbe es keine ausländischen Freunde mehr. Skypen über die Kontinente, nicht mehr drin! Von den Einschränkungen, die dann z.B. die deutsche extrem exportabhängige Investitionsgüterindustrie hätte, und den Einschränkungen im Finanztransfer ganz zu schweigen. Wegen der großen Vernetzungsabhängigkeit ist eigentlich ein „Tod des Internets“ überhaupt nicht vorstellbar (das sieht auch Lobo so). Die potentielle Schlagkraft des digitalen Spähens (falls sie denn überhaupt richtig besteht), ist relativ leicht zu brechen. Jeder Terrorist und anderer Großkrimineller wird künftig grundsätzlich das Handy und das Internet zu seinem Business vermeiden, und analoge Kommunikationstechniken aufbauen, die dann wieder nur mit ganz klassischer Geheimdienstarbeit aufzuspüren sind. Der NSA-Datenwahnsinn, der sicher nicht billig ist, könnte wegen Ineffektivität auch wieder beendet werden.

Er denkt das nicht allein, bei WIRED (Link des nebenstehenden Logos) wird weniger psychisch, dafür mehr sachlich auch über Naivität des Experten und von Balkanisierung des Internet (ein Spruch von Zuckerberg) gesprochen. Der WIRED-Autor Steven Levy rekapituliert die amerikanische Story, wie nach der Snowden-Enthüllung erst mal die großen Internetgiganten geleugnet haben, wie dann über Nachfragen aber doch zutage kam, dass sie alle ihre Datenströme der NSA übergeben, und das aufgrund der amerikanischen Gesetzgebung (FISA Amendments Act von 2008), wobei die Geheimdekrete ihnen sogar verbieten, darüber zu reden. WIRED geht es weniger um Moral und Kränkung, sondern um ökonomische Kollateralschäden einer wahnwitzigen Terrorbekämpfung, denn ein wesentliches Kapital, dass die Nutzer ihre Daten auf Amiserver schicken, besteht im Vertrauen. Und wenn dieses zerstört ist, ziehen die Firmen ihre preiswerte Datenlagerung in Clouds zurück. Die Kunden werden misstrauisch und verlassen vielleicht die amerikanisch betriebenen Plattformen. Und wenn sich gar durchsetzen würde, was in Brasilien, Malaysia, Frankreich und in der EU angedacht wird, das Internet zu nationalisieren („Splinternet“), dann wäre das der Tod des Internets, denn der aktuelle Gewinn liegt ja gerade darin global Zugang zu allen Daten zu haben. Wer dann in Brasilien im Hotel ins Netz geht, wird seine Mails aus Deutschland nicht mehr abrufen können. In Facebook gäbe es keine ausländischen Freunde mehr. Skypen über die Kontinente, nicht mehr drin! Von den Einschränkungen, die dann z.B. die deutsche extrem exportabhängige Investitionsgüterindustrie hätte, und den Einschränkungen im Finanztransfer ganz zu schweigen. Wegen der großen Vernetzungsabhängigkeit ist eigentlich ein „Tod des Internets“ überhaupt nicht vorstellbar (das sieht auch Lobo so). Die potentielle Schlagkraft des digitalen Spähens (falls sie denn überhaupt richtig besteht), ist relativ leicht zu brechen. Jeder Terrorist und anderer Großkrimineller wird künftig grundsätzlich das Handy und das Internet zu seinem Business vermeiden, und analoge Kommunikationstechniken aufbauen, die dann wieder nur mit ganz klassischer Geheimdienstarbeit aufzuspüren sind. Der NSA-Datenwahnsinn, der sicher nicht billig ist, könnte wegen Ineffektivität auch wieder beendet werden.